商机详情 -

40GH100GPU discount

H100GPU层次结构和异步性改进关键数据局部性:将程序数据尽可能的靠近执行单元异步执行:寻找的任务与内存传输和其他事物重叠。目标是使GPU中的所有单元都能得到充分利用。线程块集群(ThreadBlockClusters)提出背景:线程块包含多个线程并发运行在单个SM上,这些线程可以使用SM的共享内存与快速屏障同步并交换数据。然而,随着GPU规模超过100个SM,计算程序变得更加复杂,线程块作为编程模型中***表示的局部性单元不足以大化执行效率。Cluster是一组线程块,它们被保证并发调度到一组SM上,其目标是使跨多个SM的线程能够有效地协作。GPC:GPU处理集群,是硬件层次结构中一组物理上总是紧密相连的子模块。H100中的集群中的线程在一个GPC内跨SM同时运行。集群有硬件加速障碍和新的访存协作能力,在一个GPC中SM的一个SM-to-SM网络提供集群中线程之间快速的数据共享。分布式共享内存(DSMEM)通过集群,所有线程都可以直接访问其他SM的共享内存,并进行加载(load)、存储(store)和原子(atomic)操作。SM-to-SM网络保证了对远程DSMEM的快速、低延迟访问。在CUDA层面。集群中所有线程块的所有DSMEM段被映射到每个线程的通用地址空间中。H100 GPU 的功耗设计为 400W。40GH100GPU discount

然后剩余的总共大约6个月。初创公司是否从OEM和经销商处购买?#没有。初创公司通常会去像甲骨文这样的大型云租用访问权限,或者像Lambda和CoreWeave这样的私有云,或者与OEM和数据中心合作的提供商,如FluidStack。初创公司何时构建自己的数据中心与进行托管?#对于构建数据中心,考虑因素是构建数据中心的时间,您是否具有硬件方面的人员和经验,以及它的资本支出是否昂贵。更容易租用和colo服务器。如果你想建立自己的DC,你必须在你所在的位置运行一条暗光纤线路来连接到互联网-每公里10万美元。大部分基础设施已经在互联网繁荣期间建成并支付。现在你可以租它,相当便宜–私有云执行官从租赁到拥有的范围是:按需云(使用云服务的纯租赁),保留云,colo(购买服务器,与提供商合作托管和管理服务器),自托管(自己购买和托管服务器)。大多数需要大量H100的初创公司将进行保留云或colo。大云如何比较?#人们认为,Oracle基础架构不如三大云可靠。作为交换,甲骨文会提供更多的技术支持帮助和时间。100%.一大堆不满意的客户,哈哈–私有云执行官我认为[甲骨文]有更好的网络–(不同)私有云高管一般来说,初创公司会选择提供支持、价格和容量的佳组合的人。40GH100GPU discountH100 GPU 的高性能计算能力为此类任务提供了极大支持。

H100 GPU 在云计算中的应用也非常多。它的高并行处理能力和大带宽内存使云计算平台能够高效地处理大量并发任务,提升整体服务质量。H100 GPU 的灵活性和易管理性使其能够轻松集成到各种云计算架构中,满足不同客户的需求。无论是公共云、私有云还是混合云环境,H100 GPU 都能提供强大的计算支持,推动云计算技术的发展和普及。其高能效设计不仅提升了性能,还为企业节省了大量的能源成本。通过在云计算平台中的应用,H100 GPU 不仅提高了计算资源的利用率,还实现了资源的灵活调配和高效管理,为企业和个人用户提供了更加便捷和高效的计算服务。

使用TSMC4nm工艺定制800亿个晶体管,814mm²芯片面积。NVIDIAGraceHopperSuperchipCPU+GPU架构NVIDIAGraceCPU:利用ARM架构的灵活性,创建了从底层设计的CPU和服务器架构,用于加速计算。H100:通过NVIDIA的超高速片间互连与Grace配对,能提供900GB/s的带宽,比PCIeGen5快了7倍目录H100GPU主要特征基于H100的系统和板卡H100张量架构FP8数据格式用于加速动态规划(“DynamicProgramming”)的DPX指令L1数据cache和共享内存结合H100GPU层次结构和异步性改进线程块集群(ThreadBlockClusters)分布式共享内存(DSMEM)异步执行H100HBM和L2cache内存架构H100HBM3和HBM2eDRAM子系统H100L2cache内存子系统RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink网络第三代NVSwitch新的NVLink交换系统PCIeGen5安全性增强和保密计算H100video/IO特征H100GPU主要特征新的流式多处理器(StreamingMultiprocessor,SM)第四代张量:片间通信速率提高了6倍(包括单个SM加速、额外的SM数量、更高的时钟);在等效数据类型上提供了2倍的矩阵乘加。MatrixMultiply-Accumulate,MMA)计算速率,相比于之前的16位浮点运算,使用新的FP8数据类型使速率提高了4倍。H100 GPU 的基础时钟频率为 1410 MHz。

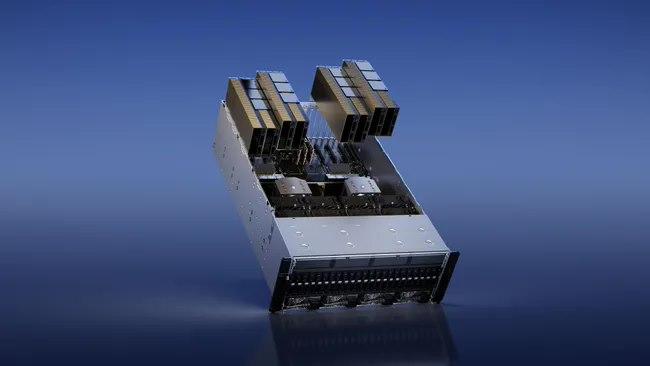

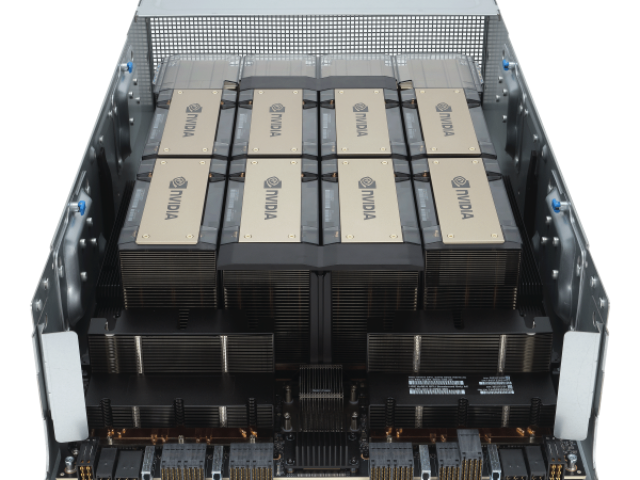

利用 NVIDIA H100 Tensor GPU,提供所有工作负载前所未有的效能、可扩展性和安全性。 使用 NVIDIA® NVLink® Switch 系统,比较高可连接 256 个 H100 来加速百万兆级工作负载,此外还有的 Transformer Engine,可解决一兆参数语言模型。 H100 所结合的技术创新,可加速大型语言模型速度,比前一代快上 30 倍,提供业界的对话式人工智能。英伟达 DGX SuperPOD架构采用英伟达的NVLink和NVSwitch系统,多可连接32个DGX节点,共256个H100 GPU。这是一个真正的人工智能基础设施平台;英伟达的DGX SuperPOD数据中心设计[4]让我们对真正的企业人工智能基础设施的巨大功率和冷却需求有了一些了解。H100 GPU 适用于虚拟现实开发。40GH100GPU discount

H100 GPU 提供高效的技术支持。40GH100GPU discount

网络、存储、RAM、CPU)以及销售它的人的利润率和支持级别。该范围的**,包括支持在内的$360k-380k,是您可能期望与DGXH100相同规格的。1xHGXH100(PCIe)和8xH100GPU大约是300k美元,包括支持,具体取决于规格。PCIe卡的市场价格约为30k-32k美元。SXM卡并不是真正作为单张卡出售的,因此很难在那里给出定价。通常作为4-GPU和8-GPU服务器出售。大约70-80%的需求是SXMH100,其余的是PCIeH100。SXM部分的需求呈上升趋势,因为PCIe卡是前几个月***可用的卡。鉴于大多数公司购买8-GPUHGXH100(SXM),每360个H380的大约支出为8k-100k,包括其他服务器组件。DGXGH200(提醒一下,包含256xGH200,每个GH200包含1xH100GPU和1xGraceCPU)的成本可能在15mm-25mm之间-尽管这是一个猜测,而不是基于定价表。19需要多少个GPU?#GPT-4可能在10,000到25,000架A100之间接受过训练。20Meta拥有大约21,000架A100,特斯拉拥有约7,000架A100,稳定AI拥有约5,000架A100。21猎鹰-40B在384架A100上进行了训练。22Inflection使用3,500H100作为其。23顺便说一句,到22月,我们有3k在运行。并且***运行超过5.<>k。——穆斯塔法·苏莱曼(MustafaSuleyman)。40GH100GPU discount